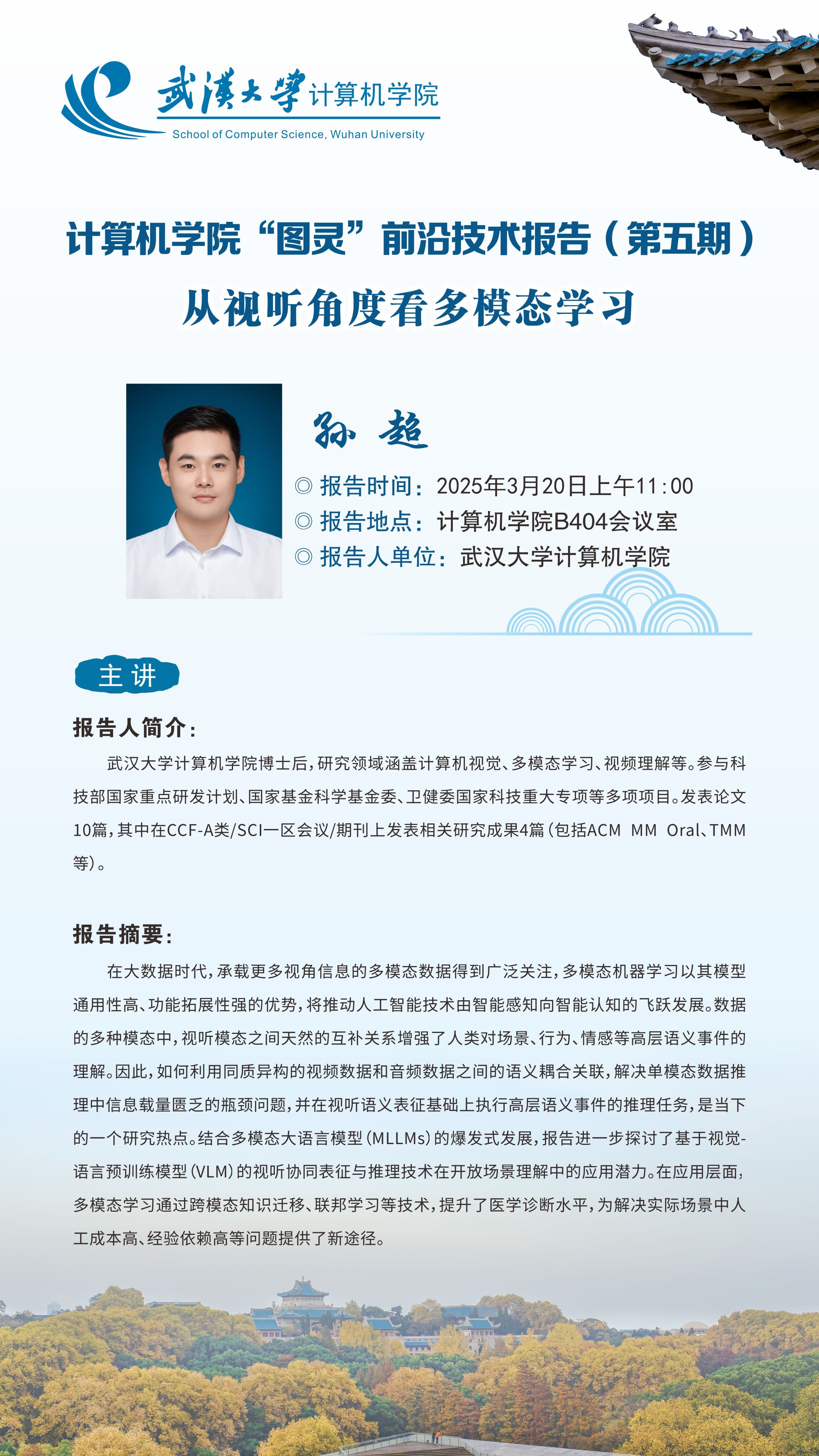

报告题目:从视听角度看多模态学习

报告时间:2025年3月20日上午11:00

报告地点:计算机学院B404会议室

报告人:孙超

报告人单位:武汉大学计算机学院

报告人简介:武汉大学计算机学院博士后,研究领域涵盖计算机视觉、多模态学习、视频理解等。参与科技部国家重点研发计划、国家基金科学基金委、卫健委国家科技重大专项等多项项目。发表论文10篇,其中在CCF-A类/SCI一区会议/期刊上发表相关研究成果4篇(包括ACM MM Oral、TMM等)。

报告摘要:在大数据时代,承载更多视角信息的多模态数据得到广泛关注,多模态机器学习以其模型通用性高、功能拓展性强的优势,将推动人工智能技术由智能感知向智能认知的飞跃发展。数据的多种模态中,视听模态之间天然的互补关系增强了人类对场景、行为、情感等高层语义事件的理解。因此,如何利用同质异构的视频数据和音频数据之间的语义耦合关联,解决单模态数据推理中信息载量匮乏的瓶颈问题,并在视听语义表征基础上执行高层语义事件的推理任务,是当下的一个研究热点。结合多模态大语言模型(MLLMs)的爆发式发展,报告进一步探讨了基于视觉-语言预训练模型(VLM)的视听协同表征与推理技术在开放场景理解中的应用潜力。在应用层面,多模态学习通过跨模态知识迁移、联邦学习等技术,提升了医学诊断水平,为解决实际场景中人工成本高、经验依赖高等问题提供了新途径。